Forord

Dette er en hovedoppgave ved Høyskolen i Oslo avdeling for ingeniør utdanning, våren 2000.

Denne oppgaven tar for seg virkemåte og problemstillinger ved design av en audio synthesizer og har som mål å belyse disse områdene og, hvis mulig, avslutte med komplett og funksjonell synth i hardware.

Elektronisk musikk har lenge vært et interesseområde for oss begge og når vi skulle velge avsluttende hovedprosjekt falt det naturlig å jobbe med elektronisk lydbehandling.

Vi vil i denne oppgaven først ta for oss de teoretiske aspektene ved en digital synthesizer og tilslutt praktisk implementasjon og test av ferdig kode og hardware.

Innholdet i denne oppgaven ligger litt på kanten av fagpensumet til de linjene vi tilhører her på skolen, som er Telematikk og Kybernetikk.

Arbeidet har derfor stort sett foregått selvstendig uten direkte faglig veiledning.

Vi vil allikevel gjerne si takk til Henry Johansen for hjelp med design og utlegg av kretskort og komponenter, Eirik Jensen ved Bit elektronikk for uvurderlig hjelp og informasjon i sammenheng med Analog Devices produkter, Stian Svendsen for utarbeiding av kabinett og Simen Filseth for hjelp med bilder til rapporten.

Til slutt vil gjerne takke vår prosjektveileder, Audun Weierholdt, for eksepsjonell goodwill og bistand ikke bare under prosjektarbeidet men også i løpet av de tre årene vi har gått på HiO IU.

Nils Petter Lyngstad Bror Gundersen

Denne oppgaven setter seg som mål å belyse forskjellige lydsyntese teknikker og DSP system design, for tilslutt å implementere en digital synthesizer.

Det diskuteres forskjellige synteses teknikker med spesielt fokus på subtraktiv syntese og hvordan denne teknikken kan realiseres i et DSP system. Dette vinkles spesielt mot Analog Devices ADSP21065L signalprosessor og Analog Devices EZ-LAB utviklingsplattform.

De forskjelllige blokkene ved subtraktiv syntese diskuteres og implementers i C kode. I tillegg diskuteres Audio effekter i sammenheng med lyd syntese

og implementeres i C.

Videre undersøkes forskjellige mikrokontroller teknologier og prinsipper spesielt rettet mot Amel M40400 mikrokontroller og Atmel EB01 utviklingsplattform. Problemstillingen rundt data innhentning med tanke på A/D omformere og mikrokontroller belyses og implementeres i maskin og programvare. Det utvikles også et egprodusert kretskort med oppgave å kople mikroprosessore systemene og A/D omformerne sammen.

Avslutningsvis integreres disse elemtene, med tilhørende programkode og kretskort utlegg, til en komplett digital syntheseizer.

Modulasjons og syntese teknikker.

Digitale filtre – Bilineære transformasjoner

Memory mapping av perifere enheter

Synthesiser programvare implementering

Analog Devices ADSP21065L SHARC DSP

Mikrokontroller - hardware prinsipper

ARM prosessor – I/O arkitektur

Atmel prosessor - Perifer arkitektur

Multiprosessorarkitektur – Kommunikasjon med prosessor på forskjellig

plattform

Komponenter i parallellbussystemet

Design av kretskort for sammenkobling av kit og plassering av

periferenheter

Mikrokontroller – software prinsipper

Innlesing av analog til digital konverter data

Parameter overføring – DMA til og fra SHARC DSP

Mikrokontroller – Software og hardware implementasjon

Atmel EB01 M40400 utviklingskit

Utviklings –software og -hardware

Hva kan så gjøres for å utbedre disse svakhetene?

Dokumentasjon for Sharc 21065L DSP prosessor, EZ kit utviklingskit og

ADI 1819 Codec

Dokumentasjon for Atmel mikrokontroller og mikrokontroller kit

Mikrokontroller periferkomponenter

Manualer til andre virtuelle analoge synther

Historie

Mennesket har alltid vært opptatt av musikk og utviklingen av forskjellige musikkinstrument har hele tiden fulgt den teknologiske utviklingen i samfunnet ellers.

Før 1900 tallet fantes det stort sett kun akustiske instrumenter . Et av de første elektriske instrumentene kom rundt århundreskiftet og ble laget av amerikaneren Thaddeus Cahill. Han laget en innretning han kalte Dynamophon. Denne bestod av en rekke dynamoer som ble styrt mekanisk og genererte forskjellige vekselspenninger innenfor det hørbare frekvensområdet. Disse spenningene ble igjen sendt via et elektrisk klaviatur, altså brytere, inn på telefonlinjer og til telefoner som igjen forsterket opp signalet ved hjelp av akustiske horn. En lite ulempe med denne maskinen var at den veiet nesten 200tonn , var omtrent 20 meter lang og laget alvorlig forstyrrelser på telefonnettet.

I 1939 kom The Hammond Organ CO’s novachord. Dette instrumentet baserte seg på 169 elektroniske vakuum rør som byggeblokker i 12 oscillatorkretser. Disse oscillatorene ble styrt av et elektronisk klaviatur. Dette instrumentet regnes som forgjengeren til dagens elektroniske audio synthesizere.

Det var først 1964 da Robert Moog konstruerte en transistor basert elektronisk synthesizer at elektroniske instrumenter foruten gitaren ble allment akseptert som noe det faktisk gikk an å lage musikk med.

Disse aller første analoge synthesizerene baserte lyd genereringen på subtraktiv syntese, som innebærer elektroniske oscillatorer og filtre. Etter dette skjedde utviklingen i takt med elektronikk revolusjonen. Synthene ble mindre, kraftigere, og fikk flere og flere stemmer.

Ved slutten av ’60-tallet og begynnelsen ’70-tallet kom de første forsøkene på å generere lyd ved hjelp av digitale computere. Datamaskinene var store og kostbare på denne tiden og var forbeholdt universiteter og store selskaper.

Etter hvert som den moderne mikroprosessoren ble tilgjenglig for konsum markedet, og på grunn av de analoge komponentenes problemer med stabilitet og temperaturdrift gikk de fleste synth produsentene over til digitale løsninger basert på sample avspilling teknikker.

Slike instrumenter programmeres ofte ved hjelp av trykk knapper og LCD display. Dette har ført til en lite intuitiv måte å jobbe med lyd på.

Med dagens raske og relativt billige Digitale Signal Prosessorer, DSP, og hjemme datamaskiner, har det dukket opp en rekke nye typer synthesizere. Mange er meget avanserte softwareprogrammer som kjøres på hjemmedatamaskiner og styres ved hjelp av musepekeren og tastaturet. En annen trend tar seg for mål å fortsatt lage fysiske synther basert på raske DSP prosessorer.

Det har blitt et behov blant musikere for enkle og intuitive musikkinstrumenter som er enkle å bruke. Derfor er det mange moderne synther som forsøker å emulere de gamle analoge synthene ved hjelp av raske signalprosessorer.

Denne typen syntheseizere kalles for Virtual Analog og kjennetegnes ved at de har mange fysiske kontroll velgere og er enkle i bruk uten behov for innviklet programmering.

Det moderne musikk studioet

Et studio oppsett inneholder stort sett en eller flere lydkilder, note sequencer, effekt enheter, en audio mikser og et opptaksmedium. I tillegg til dette kommer også en audio forsterker og høytalere.

I hvilken form disse enhetene opptrer kommer litt an på teknologien de benytter. Før i tiden var alt analogt, og de fleste delene hadde dedikerte hardware bokser. I dag blir mer og mer integrert i noen få hardware enheter. Et godt eksempel på dette er note sequencerern . En note sequencer er en enhet som sender ut note informasjon til lydkildene. Her programmeres note informasjonen enten direkte på seqenceren, eller via kontrollsignaler. I dag er den så godt som alltid implementert i et software program som kjøres på en datamaskin (PC/Mac). I tillegg blir det mer og mer vanlig å gjøre opptak direkte til hardisk på datamaskiner i samme program som sequenceren. Slike programmer, ofte kalt audio sequenserene, f. eks Stinberg’s Cubase eller Emagics’s Logic Audio, implementerer også en audio mikser slik at en fysisk miksepult i noen tilfeller er overflødig.

Som lydkilder brukes samplere og synthesizere. Dette kan være hardware løsninger, software løsninger eller en kombinasjon av begge.

For at et studio oppsett skal fungere tilfredstillende må enhetene kommunisere og utveksle kontroll signaler med hverandre.

De aller første analoge studioutstyret hadde ikke mulighet for å motta kontrollsignaler fra eksterne enheter. Det ble derfor utviklet et system, som ble kalt Control Voltage, eller CV, signalering. Med en slik løsning sendes det et analogt kontrollsignal mellom enhetene. Dette er et gammelt prinsipp og brukes ikke lengre i dag. Status quo er Musical Instruments Digital Interface, bedre kjent som MIDI. Dette er en digital kommunikasjonsprotokoll hvor de vanlige signalene, både note informasjon og generelle kontroll signaler, er definert og allment akseptert som en standard av utstyrs produsentene.

Trendene blant utstyrs produsentene går mot heltdigitale studio oppsett. I et digitalt studio blir audio signalene overført og prosessert på digital form hele veien fra lydkilde via mikser, til digital lagring på harddisk.

I et analogt studio har alle enheter analoge ut og/eller innganger. Moderne studioer er ofte hybride og benytter seg av både analogt og digitalt utstyr. Digitalt ustyr har derfor en digital-til-analog omformer på utgangene slik at de kan brukes sammen med annet utstyr på lik linje med analogt utstyr.

Prinsipper for lyd syntese

Det finnes forskjellige metoder for å generere lyd som oppfattes som musikalsk.

Som kjent består lyd av sinus bølger med forskjellige frekvenser, avhengig av tone og klangfarge. Målet for lyd syntese blir derfor å gjenskape tilsvarende frekvens spekter ved hjelp av forskjellige teknikker.

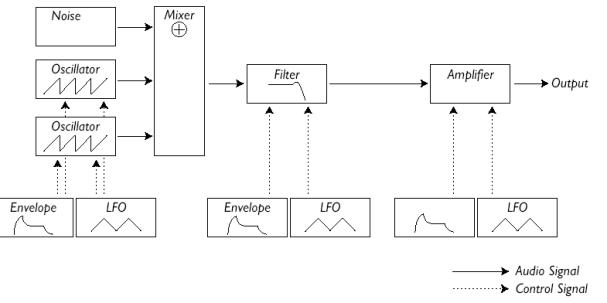

Subtraktiv syntese

Baserer seg på å generere et signal med et rikt harmonisk spektralinnhold. Dette signalet føres så inn på ett eller flere filtre. Disse er ofte av typen lavpass, høypass, eller

båndpass/båndsperre. Filtrene fjerner så en del av de harmoniske komponentene i frekvens spekteret slik at en mer presis tone og klangfarge blir igjen. Det er også vanlig å styre disse aktive elementene fra kontroll kilder.

Dette er den eldste og mest brukte av syntese teknikkene, hovedsklig fordi den er den enkel å implementere teknisk, i tillegg til at den er relativt enkel å bruke for musikeren.

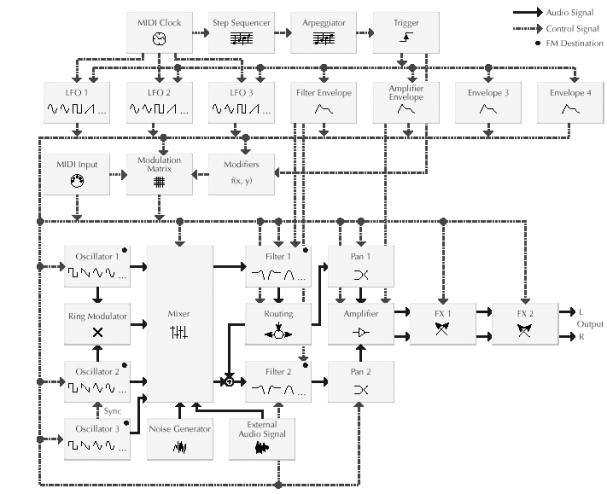

Blokkskjematisk kan en subtraktiv syntese implementering se slik ut:

Figur 1, Subtraktiv syntese

Oscillator

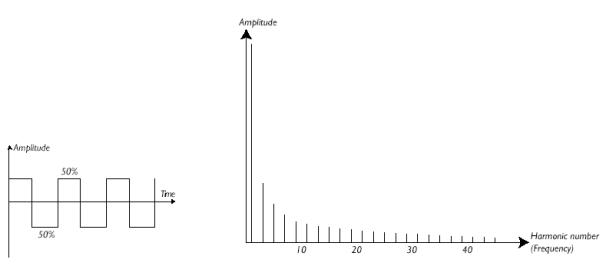

Oscillatoren er signalkilden i en subtraktiv syntese metode. Det er viktig at denne ikke er en ren sinus, siden sinus bølger ikke har harmoniske overtoner. Vanlige oscillator kurveformer er firkantbølge og sagtann bølge.

|

|

|

Figur 2, Firkant bølge og frekvensspekter

Filter

Et filter har som oppgave å slippe igjennom noen frekvenser og å hindre andre. Et lavpassfilter slipper derfor igjennom lave frekvenser og sperrer for høye frekvenser. Grensefrekvensen kalles knekkfrekvensen.

Under følger en figur som viser hvordan et

lavpassfilter behandler forskjellige frekvenser.

Figur 3 Frekvensrespons for et lavpassfilter

Figur 4, Høypass frekvensrespons

Av fysiske grunner lar det seg ikke gjøre å lage et filter som kutter helt ved knekkfrekvensen. Steilheten på dempningsflanken til filteret avgjør hvilken orden filteret har. Brattere kurve tilsvarer høyere orden. Høyere ordens filtre har også ofte en topp akkurat i knekkfrekvensen. Denne toppen kommer av en resonans i filtersystemer og gir en forsterkning for de frekvensene som ligger i knekkområdet. Det er derfor vanlig å kunne justere denne høyden på denne toppen.

Figur 5, 2.4.6.orden frekvensresponser

Det er viktig at filteret kan sveipes opp og ned i frekvens for å kunne regulere frekvens innholdet. Filteret må derfor kunne ta imot informasjon fra en kontrollkilde, for eksempel en LFO eller en omhylningskurve generator.

LFO

For å skape variasjon i lydbildet brukes forskjellige kontrollkilder til å styre de enkelte blokkene i systemet. En lavfrekvent oscillator er mye brukt til dette formålet.

Den enkleste formen for LFO er en sinusgenerator hvor frekvensen kan velges av brukeren.

Omhylningskurver

Det er ofte at det er ønskelig med andre kontrollsignaler enn repetitive signaler som oscillatorer. Omhylningskurver er en tidsbegrenset kurveform hvor formen kan justeres og til en viss grad velges av brukeren. En slik omhylningskurve betegnes ofte som en ADSR kurve etter navnet som er gitt på de forskjellige segmentene kurven består av. A står for Attack, D står for Decay, S står for Sustain og R for Release.

Figur 6, ADSR omhylningskurve

AMP

For å få riktig styrke på signalet siter det alltid en liten forsterker i enden av signalveien. Det er standard praksis at denne blokken inneholder en ADSR omhylningskurve.

Denne blokken tar også imot kontrollsignaler fra LFO og omhylningskurver.

Figur 7, Sinusbølge med omhylningskurve

Modulasjons og syntese teknikker.

Disse teknikkene baseres på prinsippet med at to relativt enkle bølgeformer kan modulere hverandre for å skape en mer komplisert bølgeform. De mest kjente metodene baserer seg på kjente teknikker fra teleteknikk, amplitude og frekvens modulasjon. Det er vanlig å finne disse funksjonene i tillegg til de vanlige kurveform oscillatorer i analoge synther.

Amplitudemodulasjon betyr at den ene bølgeformen styrer amplituden på den andre.

Frekvensmodulasjon vil si at den en ene bølgeformen styrer frekvensen til den andre.

PCM Wavetable

Små opptak, eller samples, lagres i minnet og spilles av. Lyd samplet går ofte gjennom en lydbehandlings algoritme før det sendes til utgangen, dette er derfor en hel digital teknikk.

Dette er en meget populær syntese teknikk siden den er enkel å implementere og krever i utgangspunktet svært liten prosessor kraft. De aller første digital synthene benyttet denne typen syntese. Her brukes da korte samples av bølgeformer som loopes, og derved virker som oscillator.

Hvis man også kan ta opp (sample) analoge signaler kalles det sampling.

Fysisk modellering

En relativt ny teknikk som benytter en matematisk modell av et akustisk instrument. Ta for eksempel en fløyte. Alle de fysiske karakteristikkene som utgjør en fløyte blir en variabel i en matematisk algoritme. Ved da å forandre variabelen for lengden av fløyten, vil lyden bli dypere. Siden denne teknikken krever avansert matematisk behandling stilles det også store krav til DSP systemet som programvaren kjører på. Denne teknikken er derfor ikke veldig utbredt.

Additiv syntese

Dette er som navnet tilsier det motsatte av subtraktiv syntese. Her genereres de harmoniske spektralkomponentene hver for seg og som til sammen generer en kompleks bølgeform med ønsket lyd og klangfarge.

Synther basert på denne teknikken bruker ofte en matematisk metode som kalles Inverse Fast Fourier- Transformasjoner, IFFT. Her er spektral komponentene kun matematiske operatorer i en formel som genererer en kompleks bølgeform.

For å få god nok kontroll på en lydredigerings algoritme basert på IFFT kreves det mye prosessorkraft. Ved å først analysere et analogsignal ved hjelp av vanlig FFT for å modifisere det i frekvensplanet, for tilslutt inverstransformere ved hjelp av IFFT tilbake til tidsplanet, kalles Resyntese

Dette er den hittil mest prosessorkrevende teknikken og uhyre få synther benytter seg av dette prinsippet. Det finnes sannsynligvis noen få avanserte software baserte løsninger som gjør det.

Signalbehandling

Analoge signaler er tids kontinuerlige, digitale signaler er tidsdiskrete

Figur 8, Eksempel på et tidskontinuerlig signal.

Figur 9, Eksempel på et tidsdiskret signal

Sampling

For å gjøre et tidskontinuerlig signal tids diskret, må det punktprøves. Det å punktprøve noe vil si å måle en momentanverdi av et tidskontinuerlig signal. En slik momentanverdi representeres ved en tallverdi. En enhet som utfører dette kalles en Analog-til-Digital omformer.

Figur 10, Prinsipp skisse for punktprøving

Figur 11, Et punktprøvet sinussignal.

Nyquist

For at et punktprøvet signal skal kunne gjenskapes som et tidskontinuerlig signal er det en nedre grense for frekvensen til punktprøvingssignalet i forhold til det signalet som skal punktprøves.

Dette forholdet kalles Nyquist’s punktprøvingsteorem, og slår fast at punktprøvingsfrekvensen minst må være dobbelt så høy som det signalet som skal punktprøves. Hvis dette forholdet ikke respekteres oppstår det som kalles aliasing.

Aliasing vil si at frekvenskomponenter fra det spektrumet som oppstår når noe punktprøves, finner veien inn i det punktprøvede signalet. Dette oppfattes av en lytter som en pipetone som ikke hører hjemme i lydbildet.

For å garantere at aliasing ikke skal forekomme båndgrenses det signalet som skal punktprøves med et lavpassfilter før det kommer til A/D omformeren. Knekkfrekvensen på et slikt filter er lik halvparten av den punktprøvingsfrekvensen som brukes. Et slik filter kalles derfor for et Anti-aliasing filter.

Figur 12, Aliasing

Siden punktprøvingsfrekvensen er konstant for de fleste digitale systemer, er det derfor gitt en øvre grense for hvor høye signaler et musikk systemet skal kunne behandle. Vanlige tall på punktprøvingsfrekvensen er 44.1kHz eller 48kHz. Den høyeste frekvenskomponenten et signal da kan inneholde blir i praksis rundt 20kHz.

Digital til analog omforming

Når et punktprøvet signal skal gjenskapes sendes det til en Digital-til-Analog omformer.

Det finnes flere prinsipper for å rekonstruere det analoge signalet. En vanlig måte er å benytte en såkalt trappetrinn omformer. Her holder D/A omformeren nivået på det punktprøvede signalet konstant, helt fram til neste punktprøvet. Denne sekvensen repeteres så for neste punktprøve. Et annet navn på dette prinsippet er ”Sample&Hold”.

Signalet som kommer ut av en slik D/A omformer er ofte hakkete, derav navnet. For å eliminere disse nivåsprangene plasseres det et lavpass filter som siste ledd i D/A prosessen. Dette filteret kalles for et Post-Image filter.

Z-transformasjoner

For at det skal være mulig å implementere matematiske funksjoner i digitale systemer trengs det et matematisk verktøy. Z-transformasjoner gir en metode for å speile et tidskontinuerlig signal, et differensialt system, over til et tids diskret differens system.

Ved å benytte slike transformasjoner får man en måte å benytte rasjonale funksjoner på tids diskrete signaler.

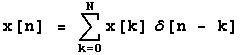

Et lengde begrenset punktprøvet signal

x[n] med lengde N kan beskrives som :

Hvor x[n] representerer en enkelt punktprøve i datastrømmen og d er en enhetsimpuls.

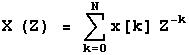

Z transformasjonen til et slikt signal

x[n] er da definert som :

Hvor z representerer et hvilket som helst komplekst tall og er den uavhengige (komplekse) variabelen til z-transformasjonen. Størrelsen på eksponenten til z forteller om tidsplasseringen til x. For kausale systemer er denne eksponenten negativ, som tilsvarer en forsinkelse. Z^-1 betyr derfor ”forrige punktprøve”

For analoge systemer er vi kjent med at komplekse vinkelfrekvenser kan substitueres med Laplace transformasjon variabelen s, på formen s=jw.

På samme måte har vi en sammenheng mellom z og w på formen z=e^jw, hvor w er digital vinkelfrekvens 2 pi f/fs.

Z-transformasjoner brukes derfor på samme måte i tidsdiskrete systemer som Laplace transformasjoner i tidskontinuerlige systemer.

Filter design

Et filter er en essensiell blokk i et lyd syntese system. Som tidligere nevnt er et filter et system som slipper noen frekvenskomponenter igjennom udempet og andre ikke. For å få en forståelse av digitale filtre kan det vært greit å først se litt på analoge implementasjoner.

Analoge filtre

For å differensiere forskjellige frekvenskomponenter er vi avhengige av elektriske komponenter som er frekvensavhengige. Spoler og kondensatorer er gode eksempler på dette. En kondensator er en komponent som lagrer elektrisk ladning og en spole lagrer et elektromagnetisk felt. Disse er komplementære når det gjelder frekvensrespons ved at ’motstanden’ i en kondensator minker ved økende frekvens og for en spole øker den. Disse egenskapene kan representeres matematisk ved XL = j 2 pi f L og XC = 1 /(j 2 pi f C) som beskriver komponentenes komplekse motstand (impedans) XL og XC. L er spolens induktans i Henry, C er kondensatorens kapasitans i Farad og f er frekvens.

Et enkelt lavpass filter kan derfor lages ved å benytte seg av disse komponentene.

Figur 13, Enkelt analogt lavpassfilter

For å få en skarpere dempning settes flere slike filtre etter hverandre i signal veien. Ved å brukes to filtre har man et 2.ordens system osv. Ved høyere ordens systemer kan det oppstå en skarp forsterkning akkurat ved knekkfrekvensen. Denne toppen oppstår på grunn av en resonans som oppstår mellom komponentene i filtret. Denne resonansen er ikke ønskelig i konvensjonelle filter anvendelser. Ved lydsyntese og spesielt ved subtraktiv syntese er denne resonansen meget spennende og gir opphav til en rekke unike lyder.

Dette systemet kan beskrives matematisk ved:

![]()

som kalles filterets overføringsfunksjon

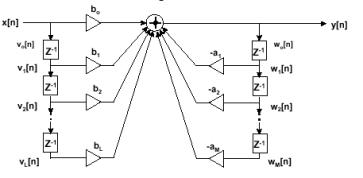

Digitale filtre – Billineære transformasjoner

Det finnes to typer digitale filtre, FIR (Finite Impulse Response) og IIR (Infinte Impulse Response). Forskjellen på disse er at FIR prinsippet baserer seg på å etterligne det signalet filtret gir ut etter det har blitt utsatt for en enhetsimpuls (Dirac puls). Dette prinsippet er relativt enkelt og lite prosessorkrevende. En egenskap ved disse filtrene er at de alltid er stabile og har derfor heller ikke resonans. Dette er uheldig for subtraktiv syntese og egner seg derfor ikke til dette formålet.

IIR metoden ligner mer på det analoge filter løsningen siden det her utledes filterkoeffisienter som signalet gjennomløper på en rekursiv måte, omtrent det samme som skjer inne i et analogt filter.

Figur 14, IIR blokk skjema

For å komme fram til et digitalt filter er det ofte enklest å gå veien om et analogt filter ved å benytte seg av sammenhengen mellom s og z. En velkjent metode går under betegnelsen Billineære transformasjoner. Denne metoden ender opp med et IIR filter, og benytter seg av sammenhengene : s = f(z) , s=jw og z=e^jw og er definert ved at s=f(z)= 1-Z^-1/1+Z^-1.

Ved å bruke overføringsfunksjonen vi fant for det analoge filteret kan vi nå ved hjelp av en bilienær transformasjon skape et uttrykk for et digitalt IIR filter.

For å bestemme konstantene må vi vite ønsket karakteristikk på filteret. Det finnes nå flere muligheter avhengig av hvilke egenskaper man ønsker å tilegne filteret. For de mest kjente filtertypene, Bessel, Chebyshev og Butterworth finnes det nå veldefinerte metoder for å bergene konstantene. En ulempe med disse filtertypene med tanke på synhtesizer design, er at ingen av disse filtertypene utvikler resonans ved knekkfrekvensen.

En mulig fremgangsmåte er beregne komponent verdiene i det analoge filteret slik at resonans oppstår.

Et annet viktig punkt ved designprosessen blir å lage filteret slik at både knekkfrekvens og resonans skal kunne varieres i sanntid. Et kritisk moment er nå å holde filteret stabilt. Et ustabilt filter vil raskt danne en meget kraftig resonans som vil, i hvert fall matematisk, øke til det uendelige.

Et stabilt filter defineres ved at røttene til både teller og nevner polynomet i filterets overføringsfunksjon, er mindre enn 1.

Ved å kun variere f. eks kondensator verdien i den analoge kretsen kan filteret fort bli ustabilt og dermed ubrukelig i musikk sammenheng.

En mulig løsning på dette er å anvende en teknikk som kalles Pol og nullpunkt design.

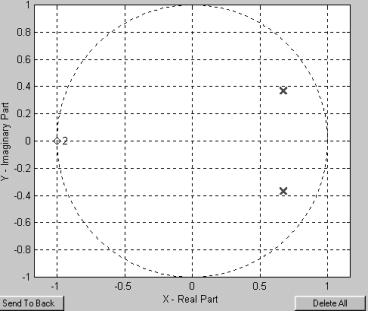

Pol/Nullpunkt design

For å få en bedre oversikt over filterets stabilitet benyttes en Pol og nullpunktsanalyse.

Hvis tellerpolynomet i filterets overføringsfunksjon H(z) er lik null sies det at filteret har et nullpunkt for denne frekvensen. Tilsvarende har filteret en pol ved den frekvensen nevnerpolynomet er lik null. Dette kan forståes grafisk ved å plotte alle polene og nullpunktene inn i en enhetssirkel, hvor realdelen er langs x-aksen, og imaginærdelen er langs y-aksen. Så lenge alle polene og nullpunktene ligger innenfor denne sirkelen (avstanden fra et punkt og origo <=1 ) er filteret stabilt.

Figur 15, Eksempel på Pol og nullpunkt plassering i en enhetssirkel

Pol og nullpunkts design prosessen er motsatt i forhold til mange andre fremgangsmåter. Man starter her med pol og nullpunktsplasseringen i enhetssirkelen og regner seg bakover for å rekonstruere teller og nevner polynomet. På denne måten regner man seg fram til koeffisienter som garanterer et stabilt filter.

Den digitale vinkelfrekvensen strekker seg fra –pi til pi. Dette er tilsvarende kjent som Nyquist intervallet. I frekvensplanet tilsvarer dette –fs/2 til fs/2, hvor fs er punktprøvingsfrekvensen. Av denne grunnen får man en dempning av frekvenser tilsvarende fs/2 hvis nullpunktene legges ved +-pi. Tilsvarende hvis en pol legges ved 0. Da forsterkes lave frekvenser. Jo nærmere punktene legges enhetssirkelen, jo mindre blir bredden på forsterkningen eller dempningen, og utslaget blir mer ekstremt. Hvis punktet ligger på enhetssirkelen er båndbredden 1 (egenresonans) og forsterkningen kan fort bli >100db.

Ved å plassere poler og nullpunkter ved ønsket frekvens og resonans kan man realisere et filter. For å oppnå best mulig resultat bør filteret ha like mange nullpunkt og poler. Et andre ordens system har to poler, et fjerde orden har fire osv.

En ulempe med denne metoden er at man aldri kan plassere knekkfrekvensen absolutt, siden denne alltid er litt forskjøvet i forhold til resonansfrekvensen.

Figur 16, 2.,4. og 6. ordens filter med sammenfallende poler.

DSP system arkitektur

I de tilfellene der det er behov for matematisk behandling av signaler er det vanlig å benytte seg av en Digital Signal Prosessor, DSP. En DSP er en mikroprosessor som er spesiallaget for matematiske operasjoner. Hvis det er analoge signaler som skal behandles, må signalene punktprøves i en analog til digital omformer før de kan sendes til prosessoren. Når de er på digital form representeres de ved en tallverdi.

En DSP kan da lese inn tallverdiene og gjøre matematiske operasjoner på signalet.

Figur 17, Prinsipp skisse for et DSP system.

Mikroprosessor teknologi

Måten en konvensjonell mikroprosessor implementerer matematiske funksjoner er ved hjelp av enkle addisjoner og subtraksjoner og logiske operasjoner (OG, ELLER og IKKE). Dette skjer i en egen blokk i prosessor arkitekturen som kalles aritmetisk logisk enhet eller ALU (fra engelsk Arithmetic Logic Unit). Dette vil si at for å implementere en multiplikasjon må det skives et lite program som utfører en rekke addisjoner og subtraksjoner. I en signalprosessor hvor disse operasjonene brukes hele tiden, finnes det en egen blokk som tar seg av dette. Denne enheten kalles MAC (Multiply ACcumulator), og bruker ofte kun en klokkepuls på en multiplikasjon sammenlignet med minst 10 eller flere uten, avhengig av tallenes størrelse og prosessor type.

Det finnes to måter å representere et tall i en prosessor. Det formatet konvensjonelle mikroprosessorer oftest benytter er ”fixed-point” formatet. Her representeres tallverdien i to komplement binær form.

Siden de matematiske operasjonene som brukes i digital signal behandling krever desimal tall, egner heltalls aritmetikk seg dårlig til dette formålet. Derfor benytter digitale signalprosessorer seg av ”floating point” eller flyttalls formatet. Her representeres en tallverdi som et eksponentialtall. Ett bit brukes til fortegn og de resterende brukes til å beskrive mantissen og eksponenten. En DSP har derfor en egen FPU ( Floating Point Unit) blokk i intern-arkitekturen.

Figur 18, Floating Point enhet

Som det går fram av figurene ovenfor er størrelsen på de interne registrene som lagrer tallverdien vesentlig for hvor stort tall som kan representeres, eller presisjonen til et flyttall.

Hvis en DSP sies å være på 32bit betyr det at registrene er på 32 bit. Det finnes imidlertid noen typer prosessorer hvor den eksterne databuss bredden er mindre enn register størrelsen. Disse betegnes da som f. eks en 16/32 bits prosessor.

For at en DSP skal kunne utføre aritmetikk på et signal må den arbeide på en langt høyere hastighet enn den signalstrømmen den skal behandle. Dette vil i praksis si at den må være raskere enn punktprøvings frekvensen til den A/D eller D/A omformeren som benyttes. Årsaken til dette er at prosessoren må kunne utføre tilstrekkelig mange flyttallsoperasjoner i den tiden som er tilgjenglig mellom to punktprøver.

På grunn av forskjeller i den intern arkitekturen ved ulike signal prosessorer, kan ikke hastigheten til prosessoren leses direkte ut fra den klokkehastigheten den jobber på.

Det som i realiteten bestemmer hastigheten er hvor mange flytallsoperasjoner som prosessoren kan utføre i sekundet, eller MFLOPS, Million FLoating-point Operations Per Second.

Tilsvarende måles konvensjonelle mikroprosessorer i MIPS, Million Instructions Per Second

I noen arkitekturen utføres flere operasjoner på en klokkepuls.

Minne håndtering

Et viktig moment i hvordan en DSP fungerer er hvordan den organiserer minnet. De fleste konvensjonelle mikroprosessorer har store mengder eksternt minne. Inne i selve prosessoren finnes det kun et lite hurtiglager, cache, som lagrer de mest brukte instruksjonene.

En DSP derimot benytter ofte mer internt minne. Ved å plassere arbeidsminnet internt i prosessoren kan den jobbe mot dette minnet med høyere hastighet enn hva man kan på den eksterne databussen.

Figur 19, CPU system

Harvard arkitektur

Et område som en DSP skiller seg fra en mikroprosessor er at signalprosessoren ofte baserer seg på Harvard arkitektur. Harvard arkitektur vil si at istedenfor å ha ett stort eksternt minneområde med en data og en adressebuss, benyttes flere uavhengige data og instruksjons busser. Hensikten med denne arkitekturen er at disse bussene kan brukes parallelt slik at flere operasjoner kan utføres per klokkepuls.

Figur 20, Harvard arkitektur

Sirkulær adressering

Når en DSP utfører en funksjon innebærer ofte dette at de samme dataene benytter rekursive operasjoner flere ganger i algoritmen. For å unngå å utføre en rekke adresseringer til det samme minneområdet bruker noen signalprosessorer en teknikk som kalles sirkulær adressering. Med en slik enhet defineres det minneområdet hvor dataene ligger av brukeren og resten styres av maskinvaren. En slik enhet forbedrer ytelsen på prosessoren i stor grad når det gjelder digital signal behandlings algoritmer.

DMA

Direct Memory Access, DMA er en egen prosessor som jobber sammen med selve kjernen i en DSP. Som navnet sier jobber denne prosessoren mot minne slik at ved store dataoverføringer kan DSP-kjernen overlate dataoverføringen til DMA prosessoren, slik at kjernen kan fortsette med program eksekveringen. Dette er meget viktig i multiprosessor systemer og andre systemer med hyppige dataoverføringer. Med tanke på digitale audio hvor det går en kontinuerlig dataflyt er det viktig at DMA kontrolleren kan kommunisere med A/D, D/A omformerne.

Memory mapping av perifere enheter

En annen problemstilling ved et signalprosesserings system er hvordan eksterne enheter kan koples sammen med en DSP. Den mest brukte måten er ”Memory Mapping”. Det vil si å lage adresserings systemet slik at hvis prosessoren adresserer minneplasser utenfor det fysiske minneområdet, velges den perifere enheten. På denne måten blir kommunikasjonen mellom prosessor og perifer enhet enkel og oversiktlig for programmereren.

Synthesizer programvare implementering

For å implementere en digital audio synthesizer er det viktig å finne ut hvilke blokker et slikt system består av. Vi hadde på forhånd kjennskap til den klassiske subtraktive syntesen:

Figur 21, klassisk subtraktiv syntesesystem.

For å finne ut hvordan lyd syntesen blir gjort i praksis valgte vi å se nærmere i eksisterende synther i den såkalte Virtual Analog sjangeren. Vi gikk litt i sømmene på både det svenske firmaet Clavia’s NordLead 1 og det tyske firmaet Waldorf sin Q. De tekniske detaljene med antall stemmer, modulasjons matriser og lignende, var ikke spesielt viktig i denne prosessen siden vi regnet med at de ville bli vanskelig å overgå. Vi la mer vekt på hvilke enheter som er med i lyd algoritmen og hvilke fysiske kontrollere de gir brukeren tilgang til, for å forsøke å designe noe tilsvarende.

Lyd algoritmen

For å få en oversikt over hvilke elementer vi burde ha med i lyd algoritmen valgte vi å kikke på blokkskskjemaene til NordLead og Q.

Ser vi først på NordLead ser vi at denne passer bra med standard oppsettet. Blokker som skiller seg ut er Støy blokken.

Figur 22, Clavia Nordlead 1.0 prinsippskisse

Q synthesizeren er en dyrere maskin enn NordLead og

har blant annet en del avanserte note sekvensierings funksjoner som faller litt

på utseiden av denne oppgaven.

Figur 23, Waldorf Q prinsippskisse.

Som vi ser har Q en relativt avansert lyd algoritme. Blokker som vi syntes var verdt å merke seg var:

o MIDI kontroll

o Filter omhylningskurve

o Ringmodulasjon av oscillatorene

o Panorering

o Effekter

Siden noe av hensikten med denne oppgaven var at vi skulle belyse de forskjellige komponentene i en audio synth valgte vi å forsøke å implementere flest mulig forskjellige blokker, men å holde disse implementasjonene relativt enkle. I tillegg til de blokkene vi har lånt fra Q og NordLead ville vi se litt på FM og pulsbreddemodulasjon.

Algoritmen vi kom fram til ble denne:

Figur 24, prinsippskisse for vår synthesizer

Hardware implementasjon

DSP

Da vi valgte denne oppgaven hadde vi ikke jobbet med digitale signalprosessorer før, og begynte med å hente inn informasjon om forskjellige typer og fabrikanter. Vi kom tidlig i kontakt med Bit elektronikk som er den norske importøren til Analog Devices. Vi ble invitert til et seminar som tok for seg deres DSP prosessor sortiment, og spesielt ADSP21065L prosessoren. Dette seminaret ga oss god innsikt i hvordan denne prosessoren fungerer med tanke på digital audio. I tillegg til informasjon, fikk vi også et komplett utviklingskort, EZ-LAB, på dette seminaret. Siden dette kortet inneholdt de fleste av de funksjonene vi regnet med å trenge til denne oppgaven valgte vi å satse på denne plattformen uten videre evaluering og undersøkelser av andre prosessor typer, for eksempel Motorola’s DSP563xx serie.

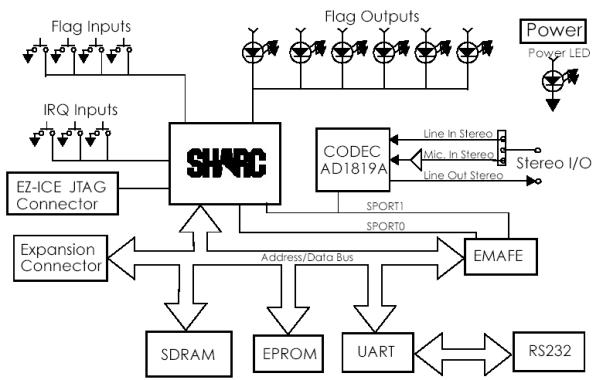

EZ_LAB

EZ-LAB plattformen fra Analog Devices benytter

Analog’s ADSP21065L SHARC signal prosessor. Integrert er også en stereo koder

og dekoder, eller codec på fagspråket. Denne tillater 16bit 48kHz stereo både

inn og ut av kortet. I tillegg til dette har det 2MB SDRAM som kan leses eller skrives på 1 klokkepuls.

Kortet har også 7 trykknapper og 6 lysdioder. Kortet koples opp mot en PC ved

hjelp av en RS-232 serieport.

Det er også mulig å kople eksterne enheter til kortet enten via en ekspansjonsbuss eller utvidelses kontakt (EMAFE).

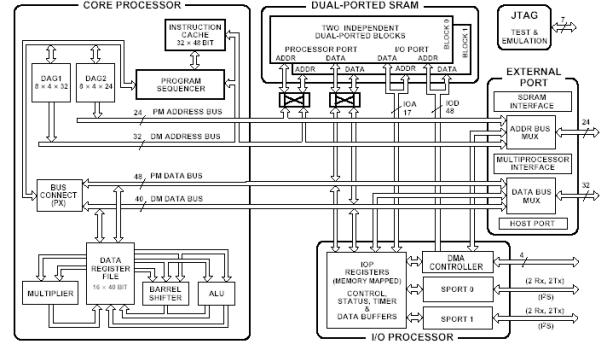

Analog Devices

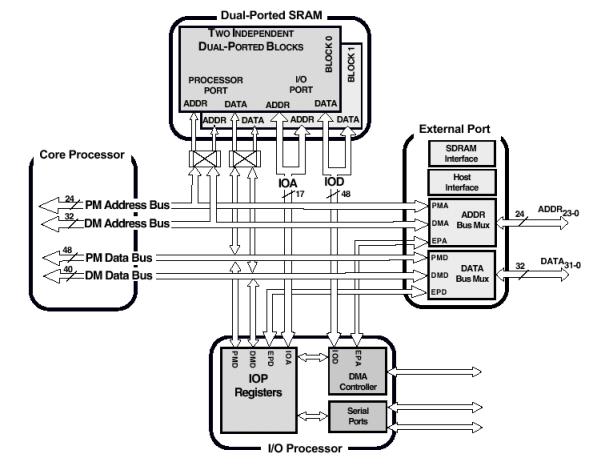

ADSP21065L SHARC DSP

Prosessoren som sitter på EZ-LAB kortet er, som nevnt tidligere, en ADSP21065L DSP, som benytter seg av Analogs SHARC arkitektur. Dette er en arkitektur basert på Harvard prinsippet, derav navnet Super Harvard ARCitecture.

Denne prosessoren har hele 4

uavhengige busser og tillater derfor en MAC operasjon, en subtraksjon

eller addisjon og lese eller skrive på

både Program og Data - databussene per klokkepuls. Denne prosessoren er et godt

eksempel på en moderne signalprosessor og brukes ofte i digitalt musikk utstyr. Her er

en kort teknisk oppsummering av prosessoren.

·

4 uavhengige busser

o

Program

memory address bus

o

Program

memory data bus

o

Data

memory address bus

o

Data

memory data bus

· 60MIPS

· Opp til 190 MFLOPS (130MFLOPS kontinuerlig)

·

32 bit

data

·

40bit

FPU

· 32 eller 40 bit sirkulær adressering

· 136k x 32bit internt minne

· Opp til 64M x 32bit eksternt minne

· 10 kanaler DMA

· 2 serieporter

Figur 26, ADSP21065L intern arkitektur

Som det kommer fram av de tekniske spesifikasjonene passer denne prosessoren utmerket til vårt formål med tanke på prosessorkraft og mulighet for tilkopling av andre enheter via DMA og serieporter.

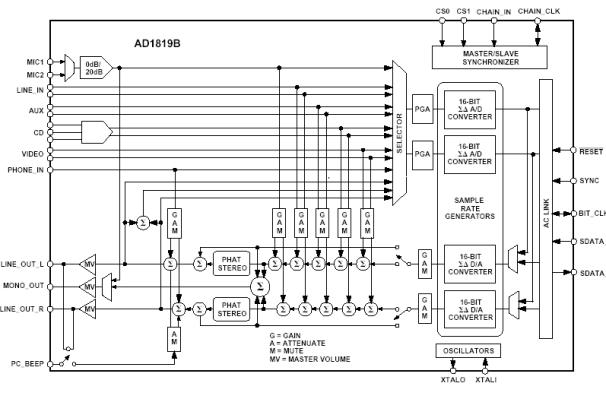

AD1819

Codec kretsen som sitter på EZ-LAB kortet er en universell IC som er beregnet på multimedia applikasjoner som lydkort til datamaskiner, telefon modem og DSP systemer. Den kan programmeres fra eksterne enheter og benytter 16bits A/D-D/A omforming med opp til 48kHz punktprøvingsfrekvens. Dette gir et signal/støy forhold på over 90db.

Figur 27, AD1819 blokkskjema

Mikrokontroller - hardware prinsipper

Valg av mikrokontroller

Etter å ha lagt linjene for selve synthesizerens hovedstruktur kom utfordringen til å tegne ned detaljene for systemets struktur. Sentralt for systemet, ved siden av lyd og effektenhetene, står mikroprosessoren. For å velge riktig mikroprosessor for systemet måtte en rekke parametere vurderes. Sammenligningsgrunnlaget vårt var:

- Intern og ekstern databussbredde forhold til DSP prosessorer og periferenheter.

- Intern og ekstern adressebussbredde i forhold til DSP prosessorer og periferenheter.

- Ytelse i forhold til klokkehastighet.

- Inn-ut ytelse på seriebusser og parallellbusser.

- Pris kontra ytelse

- Tilgjengelighet av utviklingsverktøy – både på hardware og software plattform.

- Effektforbruk i forhold til ytelse.

Valget falt på Atmels AT91M40400. Denne prosessoren kombinerer, sammenlignet med konkurrentene, flest av våre krav. De over nevnte punktene blir adressert i de videre avsnittene.

ARM – Atmel arkitektur

Atmels AT91M40400 er en mikrokontroller bygget rundt ARM’s ARM7TDMI Arm/Thumb prosessorkjerne. Atmel har bygget periferenheter rundt kjernen som er meget nyttige for vårt formål, bl.a. har prosessoren innebygde serieport kontroller, parallellbusskontrollere og avbruddkontrollere som er sentrale for synthens hardwarearkitektur, samt at det finnes minne, RAM, innebygget i kontrolleren.

ARM7TDMI kjernen er bygget opp etter RISC prinsippet, dvs. med et redusert instruksjonssett i forhold til CISC arkitektur som brukes bl.a. av Intel på PC plattform.

Få instruksjoner og få klokkesykler per instruksjon gjør prosessorens ytelse i forhold til klokkehastighet effektiv.

|

Table 6: Processors at 5 volts

in 16-bit memory systems Processor |

System |

Power (W) |

Ds1.1 MIPS |

MIPS/Watt |

|

ARM7TDMI |

33MHz 5V |

0.181 |

21.2 |

117 |

|

ARM7D |

33MHz 5V |

0.165 |

16.3 |

99 |

|

ARM710 |

33MHz 5V |

0.424 |

38.2 |

90 |

|

Z380 |

18 MHz |

0.04 |

3.1 |

78 |

|

SH7032 |

20MHz 5V |

0.5 |

16.4 |

33 |

|

H8/500 |

10MHz 5V |

0.1 |

1 |

10 |

|

486SLC |

33MHz 5V |

2.25 |

18 |

8 |

|

H8/300H |

16MHz 5V |

0.25 |

1.9 |

8 |

|

386SLC |

25 MHz 5V |

2.5 |

8 |

3 |

Figur 28, Sammenligning av prosessortyper og ytelse.

Prosessoren utmerker seg også ved at det kreves vesentlig mindre minne enn andre prosessorer med tilsvarende bussbredde fordi man kan benytte både 16 bit og 32 bit instruksjoner. Dette gjøres med en dekoder enhet i prosessoren. Generelt kan man si at 32 bit instruksjoner øker ytelsen og minnekravet, mens 16 bit instruksjoner senker programminnebehovet og strømforbruket.

Intel 386![]()

![]()

Motorola Power PC

Figur 29, Sammenligning av programminne krav for forskjellige prosessorplattformer og mellom 16 bit og 32 bit instruksjoner på ARM/Thumb prosessorer.

ARM prosessor – I/O arkitektur

Parallell I/O

Prosessoren har 16 parallell ekstern databuss og 24 bit ekstern adressebuss. Bussene styres av parallell I/O kontrolleren. I vårt system er benyttes det store adresseområde for å adressere periferenhetene for ARM prosessoren, samtidig som SRAM og Flash RAM for ARM prosessoren ligger i andre deler av adresseområdet. For at lesing og skriving til og fra periferenhetene skal fungere mest mulig optimalt under C programmering og at systemet skal fungere som et konvensjonelt mikroprosessorsystem, er enhetene koblet mot ARM prosessoren tildelt minneplasser på lik linje med SRAM.

Mer om systemet i ”Multiprosessor arkitektur” og ”Komponenter i parallellbussystemet”

Seriell I/O

ARM prosessoren har 2 serieporter, dvs. 2 seriekontrollere – USART. Disse seriekontrollerne kan operere helt opp til 1 x systemklokkefrekvens, dvs. 32,768MHz ved synkron dataoverføring. Ved asynkron dataoverføring kan overføringshastigheten være opp mot 1/16 av systemklokken. Under programmering brukes den ene porten til debugger funksjoner. Den ledige serieporten blir brukt til ta i mot og sende MIDI signaler. MIDI er en asynkron seriell overføring som er standard for musikkinstrumenter.

Overføringshastigheten ligger på 31,25Kbaud, noe mikrokontrolleren klarer med god margin, bl.a. ved hjelp av den innebygde baudgeneratoren. MIDI er en duplex protokoll som krever at serieporten, USARTen, kan sende og motta samtidig. ARM prosessoren kan i likhet med de fleste moderne mikrokontrollere og prosessorer ta seg av dette.

(se mer om ”MIDI standard – elektrisk spesifikasjon” og ”MIDI standard – softwareprotokoll”).

Minne arkitektur

Intern SRAM

8Kbyte sitter inne i prosessor pakken. Dette minnet brukes til de mest brukte variablene, og som et "cache", eller korttidsminne fordi det kan operere på prosessorens klokkehastighet.

SRAM

Atmel prosessoren kan adressere opp til 64 MByte RAM. I vårt system, og for utviklingskit'et levert av Atmel, er kontrolleren konfigurert med 512 KByte SRAM. Dette minnet sitter på den eksterne adressebussen og eksterne databussen. Det tar nødvendigvis noe lengre til å skrive og lese fra dette minnet, hastigheten kan maksimalt være ½ ganger systemklokken. Den eksterne databussen har, som tidligere nevnt, 16 bits bredde, hvilket medfører at 32 biters ord må skrives i 2 sekvenser.

Flash RAM

128KByte sitter på utviklingskit'et som brukes i systemet. Dette minnet er delt i 2. Halvparten brukes under kjøring med debug støtte i hardware med Angel software. Prosessoren booter med Angel software for å kunne debugmonitor over seriekommunikasjon med PC. Den andre halvparten brukes til å boote fra når prosessoren kjører uten debugmonitor. Prosessoren booter også fra dette minnet som frittstående enhet etter at flashminnet er programmert på forhånd. Vi skifter mellom Flash minnets to deler med en bryter på prosessorkortet.

Figur30, Atmel EB01 M40400. Hentet fra EB01 User’s Manual

Figur 31, Mikrokontrollerens indre arkitektur.

Figur 31, Mikrokontrollerens indre arkitektur.

Enhetenes rolle i systemet er omtalt i kapitlet "Valg av mikrokontroller”.

Atmel prosessor - Perifer arkitektur

Atmel prosessorens oppgave er å lese inn verdier fra bruker input, behandle parameterne for deretter å sende disse til en av DSP prosessorene. Atmel prosessoren styrer også displayet og genererer grafikk og karakterer for dette. For å ta seg av oppgavene bruker vi flere periferenheter. Disse er i gruppene analog til digital konvertere, adressedekoder, vipper og bussdrivere. Atmel prosessorens eksterne minne er plassert på EB01 utviklingskit'et. Alle andre periferenheter som kommuniserer serielt eller parallelt med mikrokontrolleren skal plasseres på et egenutviklet sammenkoblingskort. En av DSP prosessorene kobles også til på sammenkoblingskortet for kommunikasjon med mikrokontrolleren over. Mer om sammenkoblingskortet under punket ”Design av kretskort for sammenkobling av kit og plassering av periferenheter” og mer om kommunikasjon mellom mikrokontroller DSP prosessor.

Multeprosessorarkitektur – Kommunikasjon med prosessor på forskjellig plattform

Atmel prosessoren og SHARC DSP prosessoren har forskjellig grensesnitt når det gjelder kommunikasjon over parallellbuss. Atmel prosessoren kan sende 16 data biter i parallell, mens DSP prosessoren kan sende data biter med opp til 32 biters bussbredde. Dette løses ved å sende og motta fra de nederste minst signifikante bitene. DSP prosessoren har støtte for denne typen kommunikasjon.

For at kommunikasjonen skal bli uavhengig av prosessorenes forskjellige asynkrone klokkehastigheter må det lages et bufferminne mellom bussene. Vi bruker 4 oktal flanketriggede D-vippe for hvor dataene legges ut før de hentes inn på den respektive prosessoren avhengig av hvilken vei dataene går.

Dataoverføringen går med en protokoll hvor overføring alltid initieres av Atmel prosessoren.

Kommunikasjonen kan går begge veier.

Det er flere muligheter for sammenkobling av Atmel og SHARC prosessorer avhengig av hvor stor kontroll mikrokontrolleren skal ha over DSP prosessoren. Hovedtypene av sammenkobling er ”External Port DMA” (EPD) og ”Host Processor Interface” (HPI).

HPI tillater en ekstern prosessor å styre SHARC prosessoren, dvs. kontrollere eksekvering av kode, og kontroll av SHARC prosessorens interne registre. Denne kontrollen gir utstrakt mulighet til og skrive og lese til prosessorens minneområde og kontrollere hvor dataene legges i SHARC minnet. Dette krever en sammenkobling av adresselinjer, datalinjer og en rekke kontrollinjer til den eksterne prosessoren. (se vedlegg: ADSP-21065L SHARC, User's Manual, Figur 7-1) HPI er relativt omfattende og krever adresselinjer og flere komponenter enn EPD.

Med EPD har ikke den eksterne prosessoren, i vårt tilfelle Atmel prosessoren, kontroll på hvor overført data legges i SHARC minnet. SHARC prosessoren bestemmer hvor data legges, og hvor data kan hentes fra, men selve overføringen initieres fra Atmel prosessoren. EPD krever færre linjer enn HPI, færre hjelpekomponenter og er enklere å implementere enn HPI både i software og hardware. EPD kan operere opp mot busshastighet på Atmel prosessoren og fungerer bra i vårt system fordi mikrokontrollerens oppgave mot DSP prosessorene i systemet er å kun overføre parameterdata til DSP prosessorenes variable. Mer om hvordan protokollen mellom Atmel og SHARC finnes i software kapittelet om ” Parameter overføring – DMA til og fra SHARC DSP”.

Figur 32, Systemets hardwarearkitektur og busstruktur.

Komponenter i parallellbussystemet

Analog til digital omformere (ADC) – Analog Devices AD7859

For å kunne lese inn spenningsverdier fra potensiometere på synthesizerens kontrolloverflate er det nødvendig med 48 ADC innganger. Det vil være urasjonelt å bruke 48 separate ADCer både økonomisk, plassmessig og elektrisk. Et alternativ kunne vært å bruke pulspotensiometre med uendelig vridning. Prisen per potensiometer for dette alternativet overskred den valgte løsningen med nærmere 10 ganger, og ble avskrevet av hensyn til det totale kostnadsnivået. For å få tilstrekkelig antall innganger vurderte vi forskjellige multipleksingsteknikker. Utviklingsverktøyene tilgjengelig tillot ikke utstrakt simulering av komplekse multiplekser systemer, derfor besluttet vi å velge en løsning med størst mulig forutsigbarhet og kontrollerbarhet. Det er også viktig for optimalisering av ytelsen til mikrokontrolleren at ADCen har parallell dataoverføring, og at den kan tildeles en adresse i Atmel prosessorens minneområde.

Figur 33, Analog til digital omformerens hjelpekomponenter og prosessortilkobling. Figur hentet fra AD7859 datablad, med modifikasjoner for tilpasning til vårt system.

ADCene vi valgte er softwarestyrte hvor mikrokontrolleren leser og skriver til interne registre i hver ADC. ADCene følger samme buffrede klokke, men er ikke avhengige av synkronisering seg i mellom. ADCene kan sample med opp til 200KHz. Denne høye samplingsfrekvensen minimerer behovet for antialiasingfiltere på inngangene. Utlesing av data er softwarestyrt slik at avlesingsfrekvensen kan styres softwaremessig for å tilpasse hastigheten til det aktuelle parameteren og hvor rask oppdatering som behøves.

Konverter funksjon – AD7859

Figur 34, Funksjonsdiagram AD7859

Se også datablad for AD7859/AD7859L

Referansespenning

Konverteren har Vdd = 3,3V spenningsforsyning, og inngangssignalene fra potensiometrene varierer mellom 0-3,3V minus spenningsfall i ledere. Vi har ikke tatt hensyn til variasjon i potensiometrene fordi det ikke er viktig med stor presisjon i avlesning av minimums og maksimumsutslagene bare disse holder seg innenfor 0-3,3V. Vi benytter den interne referansespenningen i konverteren. Konverteren blir internt kalibrert før konvertering starter.

Kvantisering

Dataene leses ut med 16 bit bussbredde (mer om utlesings protokollen i ”Mikrokontroller software prinsipper” kapittelet), hvor de 12 minst signifikante bitene brukes til å kode signalet. Med 3,3V som fullt utslag gir dette 3,3/(2^12) = 0,8mV per steg i konverteringen.

I vårt design har vi lagt vekt på at endring i parametere skal ”føles og høres analoge”, dvs.. at det ikke kan oppfattes diskrete nivåer ved endring i parametere som for eksempel endring i filter knekkfrekvensen eller resonanshøyden i filteret. Den høye oppløsningen skal bidra til å minke effekten av kvantisering mellom nivåer.

Det er aktuelt for senere utvidelser å implementere ”MIDI Realtime Controller” sending på ”MIDI OUT” porten. Disse sanntids kontrollsignalene kan sendes med en oppløsning på opp til 14 bit. AD7809 sampler med 12 biters oppløsning, hvilket er tilstrekkelig for parametersending over MIDI. Mer om ”MIDI Realtime Controller” og ”MIDI OUT” i softwareprinsipper.

Klokkekrets til ADC

ADCene bruker en 4MHz klokke under operasjon. Klokkesignalet hentes fra en konvensjonell krystall klokke krets laget med et krystall, kondensatorer, en ubufret inverter (74HCU04) og en oktal Schmittrigger(74HC. Schmittriggeren sørger for å lage mest mulige steile flanker på klokkepulsene, samt at den fungerer som distribusjons buffer til de 6 ADCene. Triggerinngangene er koblet på ”out” i kretsen tilsvarende ”out” i figuren under.

Figur 35, Klokkekrets, hentet fra 74HCU04 manual.

Display – Seiko G242C

Enhetens display skal presentere relevant informasjon for brukeren av synthesizeren om aktuelle parameterdata og brukerkonfigurasjon av DSP algoritmene. Størrelsen på displayet var av viktig karakter. Ønsket var å få et stort nok display til å kunne tegne grafikk samtidig som vi enkelt kan skrive karakterer. All grafikk og tekst må være leselig på god avstand. Vinkelen for hvor skarpt brukeren kan stå og samtidig lese displayet har betydning når brukeren ikke alltid er plassert foran displayet under bruk. Seiko G242C har 240 X 128 pixler og innebygget driver med karaktergenerator og grafikkgenerator. Display overflaten er 122,36mm X 65,24mm stor. Grafikk og tekst på G242C kan sees opp til q2 = 55° (se figur under for q2 definisjon) ut fra en akse som står 90° på displayet.

Figur 36. Definisjon av leselighetsvinkel

De forhåndsdefinerte karakterene er 5 X 7 pixler, og det er mulig å definere sine egne karakterer som kan legges i displayets minne. Det er 8Kbyte karakter RAM i displayet for egne karakterdefinisjoner.

Både for at leseligheten skal være god og at det er høyst nødvendig å kunne avlese displayet i mørke eller i dårlig lys, valgte vi å bruke et bakgrunnsbelyst display. Av hensyn til Arm prosessorens ytelse er den 8 biters databussen på Seiko displayet å foretrekke fremfor en løsning med seriell kommunikasjon. Parallellbussen gjør det også mulig å tildele displayet en minneadresse i Arm prosessorens minneområde. Bussen har et standard mikroposessorgrensesnitt med signalerings linjer for konvensjonell lesing og skriving til minnet i displayet.

Prinsipper for displayets virkemåte – prosessorkrav

Skriving av grafikk til et display krever mer ressurser enn å skrive karakterer til et rent karakterdisplay som brukes i tilsvarende applikasjoner. Skriving av grafikk til displayet foregår ved skrive 8 pixler av gangen. Det betyr at det tar (128 x 240)/8 = 3840 skrive operasjoner for å fylle displayet en gang. Fordi dette er relativt krevende må vi ta hensyn til hvor raskt vi velger å oppdatere grafikken, slik at dette ikke går ut over sanntidsytelsen til parameteroppdateringen og MIDI.

Inverter – ILP-324-INV

Som spenningsforsyning til displayet brukes en inverter levert av Seiko. Kretsen sitter på et eget kretskort med 5 V spenningsforsyning, og gir mellom 850 til 1300V AC ved 25 til 45 KHz ut til displayet.

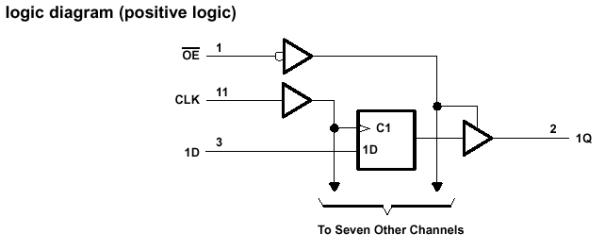

D-vipper for DMA overføring mellom Atmel og SHARC prosessor - 74HC374

Vi bruker 4 oktal positiv flanke triggede D-vipper med 3-state utgang som buffer mellom prosessorene for å tilpasse busshastighetene som nevnt i punktet ”Multiprosessorarkitektur – Kommunikasjon med prosessor på forskjellig plattform” . Vi er avhengige av at disse latchene følger busshastigheten. Med 3,3V i forsyningsspenning valgte vi å bruke vipper i 74HC familien med typiske fall og stigetider på 1 nS. Maksimal busshastighet kan ligge opp mot Atmel klokke delt på 4, dvs.. 1/systemklokke/4 = (1/32768000Hz)/4 = 0,12 ms. Vi bruker 4 vipper for å gi totalt 32 linjer – 16 inn og 16 ut fra SHARC prosessoren (se fig. 32 for hardwarearkitektur) Vippene er tildelt adresser i Atmel prosessorens adresseområde. Mer om funksjon i punktet ” Parameter overføring – DMA til og fra SHARC DSP”. Det er viktig at utgangene som legger data ut på DSP databussen har mulighet for å settes i høyimpedant tilstand for å ikke forstyrre DSP prosessorens kommunikasjon med SRAM på DSP utviklings kitet.

Figur 37, Logikkdiagram for 74HC374

Adressedekoder – 74HC154

Vi bruker en 4 til 16 linjers adressedekoder som er koblet til de 4 øverste adresselinjene på mikrokontrolleren. Denne er med på å adressere alle mikrokontrollerens periferenheter. Denne brukes for å spare adresselinjer som brukes direkte fra mikrokontrolleren, og for å bruke adressene som ligger over adresseområdet til mikrokontrollerens eksterne SRAM. Vi bruker c-mos HC serie for å klare busshastigheten på mikrokontrollerens adressebuss som operer opp til systemklokke delt på 2 – 32,768MHz/2 = 16,384MHz. Prosessorbussene er designet med c-mos teknologi og HC serien er kompatibel med denne, og drives med 3,3V spenning for tilpasning til resten av mikrokontrollerens periferenheter. Se elektronisk vedlegg for logisk funksjonsbeskrivelse av 74HC154.

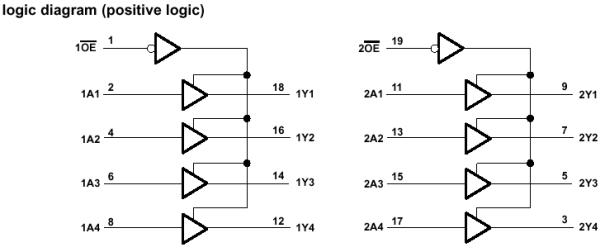

3-State linjedriver – 74HC244

Sammenkoblingskortet er utstyrt med 3 oktal 3-state bussdrivere

Denne bussdriveren skal ta i mot signaler fra knapper som sitter på synthens kontrollpanel.

Disse knappene har glitchfilter for å unngå rippel på driverinngangene. 3-state utgangene skal sørge for at mikrokontrollerens databuss ikke forstyrres av knappeaktivitet under skriving og lesing til andre enheter, samtidig som disse er adressert fra mikrokontrolleren (se vedlegg for hvordan bussdriveren er memorymappet). Vi bruker HC serie drivere for å kunne operere under full hastighet på databuss. Bussdriveren bruker 3,3V spenningsforsyning for tilpasning til mikrokontrollerens 3,3Volts busser.

Figur 38, Logikkdiagram for linjedriver 74HC244.

Komponenter for seriebuss

MIDI hardware standard

MIDI eller Musical Digital Interface er en standard for kommunikasjon mellom musikkinstrumenter. MIDI brukes til å sende enkle note beskjeder og kontrolldata til og fra MIDI bestykket utstyr. MIDI kommunikasjonen foregår med asynkron seriell dataoverføring. Inngang og utgang på kommunikasjonskanalen er adskilt, dvs.. at det er en 5 pins DIN plugg for utgang og en 5 pins DIN plugg for inngang. De fleste MIDI enheter har i tillegg en THRU utgang som er en bufret versjon av inngangen for å kunne koble sammen flere enheter i en kjede. Her er det underforstått at det kun kan kobles en enhet til per inn eller utgang for å ikke overlaste bufrene eller få andre konflikter. I den 5 pins kabelen brukes 2 ledere, en for jord og en for signal, i tillegg kan eventuell skjerm i kabel tilkobles pluggens ytre kappe i den ene enden. Det er viktig at den ytre skjermen ikke kobles til i begge ender for å unngå jordsløyfer.

Figur 39, MIDI-kabel.

MIDI er en strømsløyfe med 5mA og 5V som logisk 0 og jord som logisk 1. Overføringshastigheten er 31,25 Kbaud +/- 1%, og er i vår applikasjon koblet videre til en av serieportene på mikrokontrolleren. Det overføres et bit per klokkepuls. MIDI signalene er kodet i byter, men for å sikre stabilitet i overføringen har byten et startbit og et stoppbit, m.a.o. 10 biter totalt. Atmel prosessoren har innebygget seriekontroller som generer riktig baudrate, samtidig som den tar seg av synkroniseringen av datamottak, samt fjerning av start og stopp bit. MIDI-trafikken på bussen er hendelsesavhengig.

Se mer om MIDI software protokoll spesifikasjon i softwareprinsipper og i det elektroniske vedlegget.

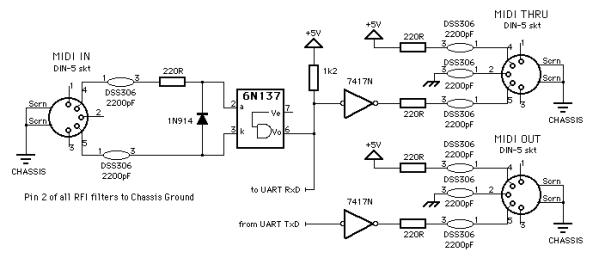

MIDI krets

Vi følger i hovedsak prinsippene for en standard MIDI krets som er anbefalt av MIDI Manufacturers Association, med noen få endringer for å tilpasse MIDI IN til 3,3V serieport på Atmelprosessoren. Vi har også valgt å bruke en annen inverter som bl.a. har c-mos kompatible innganger (www.midi.org for anbefalte spesifikasjoner av MMA).

Figur 40, MIDI-krets

MIDI IN og MIDI THRU

Inngangen er optoisolert med en 6N139 for å unngå jordsløyfer i signaljord. Det er viktig å merke seg at signaljord ikke er koblet til felles jord på kretskortet eller på annen måte. Det sitter også en diode i parallell med signalveien som fungerer som ”gnistfanger”, dvs.. for å unngå store spenninger inn på optokobleren i motsatt vei av driftsområdet. MIDI-signalet er som tidligere nevnt invers kodet med logisk 0 = 5V og 1 = 0V, derfor brukes en pullupmotstand på sekundærsiden for å invertere signalet for tilpasning til seriekontrolleren som har logisk 1 = 3,3V og 0 = 0V. Optokobleren har 3,3V forsyningsspenning i vår konstruksjon for å senke spenningen til seriebusskompatibel spenning. Seriebussen tåler maksimalt 4V (se ”40400 errata” i elektronisk vedlegg)

Sekundærsiden er videre koblet til en 7407 inverter og til MIDI THRU for å kunne sende MIDI-signalet til en ny enhet i en kjede, uten at signalet er modifisert av vertsenheten. Det sitter RC serie filtre med komponentverdier R = 220 Ohm og C = 2200pF på alle tilkoblinger. Dette høypassfilteret skal hjelpe til med å fjerne lavfrekvente komponenter som nettstøy og DC. Filteret har knekkfrekvens ved 1/RC = 1/(2200e-9 * 220) = 2066 radianer = 329Hz. Det vil si at man fjerner deler av 5 harmoniske komponenter fra 50Hz nettfrekvens, i tillegg til andre støykilder med lavfrekvente og ofte energirike frekvenskomponenter.

MIDI OUT

Send kanalen på seriekontroller 1 brukes for å sende data fra vertsenheten. Dataene som passerer ut på denne kanalen går til en inverter før den sendes ut på porten, dvs.. tilkoblingen. Det er kun data fra selve synthesizeren som sendes ut på porten og ingen av dataene som kommer inn på MIDI IN. De samme RC leddene som finnes på MIDI IN og THRU sitter også på MIDI ut delen av MIDI-kretsen. Se punktet MIDI OUT og MIDI THRU for forklaring av filtrenes misjon.

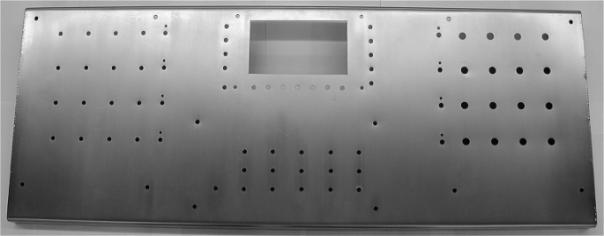

Design av kretskort for sammenkobling av kit og plassering av periferenheter

Komponentene omtalt i kapittelet ”Atmel prosessor - Perifer arkitektur” skal plasseres på et eget designet kort bort sett fra displayet som er plassert på et ferdig kort levert av Seiko. Kortet er designet med Traxedit og legges ut på HiO IU.

Det er en rekke hensyn å ta for å legge ut et sammenkoblingskort for mikrokontrollerbuss. Kortet skal legges ut på et 2 lags prototypekort. Prinsippene for utlegg av sammenkoblingskortet, som er beskrevet i punktene under, er idealiserte og ikke 100% realiserbare innenfor de begrensninger et 2 lags kort gir. Dette er det nærmere redegjort for på s. XX. Se elektronisk vedlegg for kretskortutlegg.

Bussdesign

Sentralt på sammenkoblingskortet er Atmel prosessorens databuss og adressebuss. Hastigheten på bussene kan ligge opp til halvparten av Atmel prosessorens klokkehastighet, dvs.. 32,768MHz/2 = 16,384MHz. Den raske svitsjingen på bussen kan føre til problemer med støy som både virker inn på komponenter og andre linjer på kortet i tillegg til at strålingen kan virke på elektronisk utstyr på utsiden av synthesizeren. For å begrense crosstalk på kortet, er del konstruksjonene plassert mest mulig adskilt på kortet. MIDI kretsen som operer på en langt lavere klokkefrekvens enn Atmel bussene er plassert på et eget område. DSP – Atmel kommunikasjonen foregår på den ene siden av Atmel busstilkoblingen, mens analog til digital omformerne er plassert på den andre.

Linjeekvivalens

Når signaler skifter med høy frekvens må man betrakte signalene som radiobølger, hvilket medfører at man må ta hensyn til bølgeteori i tillegg til de elektriske spesifikasjonene. Banene på kretskortet har kapasitive og induktive egenskaper. Overflater med avstand mellom seg har kapasitiv spenning mellom seg. For klokke og bussignalene i vår konstruksjon virker kapasitansen som filter som forlenger logikktransisjonstiden. C-mos komponentene har en maksimum transisjonstid som ikke må overskrides hvis systemet skal operere stabilt. På sammenkoblingskortet har banene minst mulig bredde og gjennomføringene minst mulig dimensjon for å gjøre overflatene små, og dermed flatene i den kapasitive koblingen minst mulig. For å få færrest mulig kapasitive koblinger, har hver bane færrest mulig gjennomføringer.

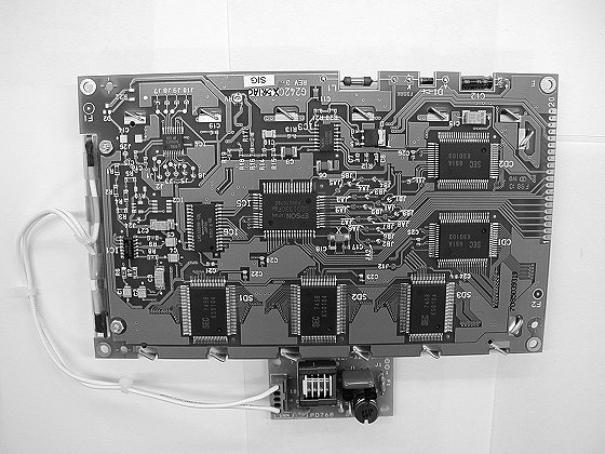

Når det fullstendige hardware systemet skulle settes opp måtte vi sette oss ned med de komponentene vi valgte ut for å se om de lot seg gjøre å lage et funksjonelt system ut av dem.

Et problem var at vi ikke på forhånd visste hvor mye prosesseringskraft vil ville trenge for de forskjellig programvare blokkene. Vi tok en titt under panseret på en NordLead, og konstaterte at den kun brukte en Motorola DSP56302. Ved å ta en liten kikk på blokkskjemaet til denne synhten ser vi at det består av relativt få blokker og ingen effekter. Siden den algoritmen vi hadde tenkt å implementere besto av flere blokker og i tillegg effekter, regnet vi med at den ville bli tyngre for prosessoren. I tillegg til dette er ingen av oss noen kunstnere når det gjelder programmering og kommer sannsynligvis til å lage en lite effektiv kode.

Etter ”føre var” prinsippet og et raskt overslag (klokkehastighet/fs) Fant vi ut at det ville være fornuftig å bruke 2 DSP enheter, en for lyd generering og en for effekter.

Et problem som da umiddelbar meldte seg var hvordan vi skulle kople mikrokontrolleren og de to DSP prosessorene sammen i tillegg til hvordan vil skulle hente inn informasjon fra skruknappene.

Mikrokontroller – software prinsipper

Mikrokontroller softwaren skal kombinere kommunikasjon med periferenhetene samtidig som det foretas omregning og sortering av parametere. Det er viktig at softwaren bevarer sanntidskravene som kreves for at parametere oppdateres i tilstrekkelig tid slik at det ikke kan oppfattes uregelmessigheter i lydgjengivelsen. Det er generelt viktig at programflyten er kontinuerlig og ikke ender i tidkrevende venteløkker.

Hovedmetode – main()

Main metoden er planlagt slik at flyten i hovedprogrammet bevares. Det brukes hardwareinterrupt for hendelsbaserte programdeler som MIDI mottak på serieporten.

Hardwareinterrupt brukes også når prosessoren venter på å sende data til DSP prosessoren.

Figur 41, Hovedflyt i Atmelprogram

main() programmflyt.

Innlesing av analog til digital konverter data

Alle potensiometere som er plassert på kontrolloverflaten blir lest inn av 6 analog til digitalkonvertere hver med 8 innganger, til sammen 48 parametere. Disse parametrene blir lest av i en sekvens hvor en adresse blir lest 8 ganger før neste adresse leses (adressebeskrivelse se vedlegget). Dette gjentas 6 ganger til alle parametere er avlest. Før avlesingsrutinen, adc_load(), startes settes ADCene opp til konvertering med en adc_init() metode og gjøres klare til opplasting av data.

Når løkken med 48 avleste verdier er ferdige, sammenlignes alle parametere med den forrige avleste verdien. Hvis verdien avviker fra den forrige, oppdateres parameteren i et DMA buffer. Bufferet sendes så til DSP prosessoren i sin helhet. Se mer under ”Parameter overføring – DMA til og fra SHARC DSP.

Innlesing av knappeverdier

Innlesing av knappeverdier foregår ved avlesing av 2 adresser i prosessorens minneområde. For spesifikasjon av adresser se ”definisjon av knappekonfigurasjon” vedlegg. Knappeverdiene sorteres og sammenlignes med forrige verdi. Hvis verdien avviker fra forrige innleste, oppdateres bufferet for sending av parametere over DMA. Parametrene sendes til DSP prosessoren sammen med resten av verdiene som ligger i DMA bufferet.

Parameter overføring – DMA til og fra SHARC DSP

Innleste knappeverdier, potmeter verdier og MIDI data som er relevante for DSP prosessoren blir sendt som en tabell over til SHARC prosessoren. Tabellen sendes kun når det er endring i en eller flere variable. DMA overføringen foregår ved at Atmel prosessoren initierer en DMA overføring til DSP. Det er kun DSP prosessoren som har støtte for DMA. DSP prosessoren skriver til eller leser fra et fast definert minneområde som er satt opp i SHARC DMA kontrolleren. Fra Atmelprosessoren side foregår overføringen med skriving og lesing fra 2 forskjellige minneområder som tilsvarer D-vippene mellom prosessorene. Signaleringen mellom prosessorene foregår ved at hver gang det skrives eller leses fra en vippe sendes det samtidig en forespørsel til DSP prosessoren om overføring. Når forespørselen bekreftes starter dette signalet en av to avbruddsrutiner på mikrokontrolleren, avhengig om det skal leses eller skrives. Avbruddsrutinen fullfører overføringen, og starter skrivingen av neste verdi i tabellen. Dette gjentar seg til hele buffer tabellen er skrevet eller lest. Adressedefinisjon finnes i memorymapping definisjonen i kodevedlegget.

MIDI

MIDI protokoll

MIDI software protokollen skal utveksle data mellom forskjellige MIDI bestykkede enheter. Det kan dreie seg om kommunikasjon mellom forskjellige enheter som f.eks. vist i figuren under.

Figur 42. MIDI system hentet fra MMA

Hensikt med MIDI

MIDI er enkle meldinger som overfører note informasjon, kontrollmeldinger til og fra MIDI enhetene, systeminformasjon til og fra MIDI enhetene og sanntidskontroll meldinger. MIDI kan overføre samplinger, men dette er ikke i sanntid, og ytelsen er så dårlig at det sjelden er aktuelt. Over MIDI vil 10 sekunder med lyd i mono, 16 bits oppløsning og 44,1KHz samplingsfrekvens bruke (44100 x 10 x 16/2)/31250 = 28,224 sekunder, i tillegg kommer andre systemsignaler. Erfaringsmessig bruker overføringen lengre tid. Det finnes andre løsninger for dette på markedet som bruker ca 1/10 eller mindre tid.

MIDI koding

MIDI informasjonen er representert i byter dvs.. 8 bit. Den første biten brukes til å angi om informasjonen er en statusbyte eller en databyte. Det betyr at det er 7 bit til å kode resten av informasjonen, hvilket gir 127 kombinasjoner. For enkelte sanntidskontrollparametere brukes to og to byter til å kode informasjonen, dette gir til sammen 14 biters oppløsning, hvilket gir 16384 nivåer. Et eksempel på dette er ”Pitch Wheel”, eller tonehjul, som kan brukes til å øke eller senke frekvensen uten at man hører de diskrete nivåene mens man skifter opp og ned.

Vi går ikke nærmere inn på spesifikasjonen av alle forskjellige MIDI data definisjonene, mer om dette finnes i det elektroniske vedlegget under ”MIDI 1.0 Spesifikasjon MMA”.

MIDI protokollbeskrivelse

MIDI protokollen består som tidligere nevnt av statusbyter og databyter. Generelt gjelder det at en sekvens av data starter alltid med et statusbyte. Deretter følger 0,1,2 eller et ubestemt antall databyter, avhengig av hva slags statusbyte som kom først i sekvensen. Statusbytene deles opp i 2 nibbels som forteller hva slags type MIDI parameter det er snakk om. Mer om protokollen i det elektroniske vedlegget under ”MIDI 1.0 Spesifikasjon MMA”.

MIDI algoritme

I den første versjonen av vår MIDI algoritme har vi konsentrert oss om note på, ”note on” og note av, ”note off”. Note on og note off kan sendes til 16 forskjellige instrumentlyder med 127 forskjellige noteverdier til hver av instrumentene. Det er forhåndsdefinert i DSP software hvilken instrumentkanal noteverdier tas i mot på. MIDI algoritmen i mikrokontrolleren har som oppgave å sende instrument nummer og notenummer sammen med note på eller av for den respektive noten. Informasjonen sendes som en del av DMA parameter tabellen. I DMA tabellen settes bit som forteller om det finnes ny MIDI informasjon som ennå ikke er lest og hva slags type ny MIDI byte som sendes.

Figur 43 , Inndeling av midinoter, instrumenter i forhold til kanal

Figur 44, Programflyt i MIDI algoritme

Display

Det er ikke utviklet metoder for displaykommunikasjon.

Lyd-Blokkene –DSP prosessor

Sammen med EZ-LAB fulgte det med et utviklingsmiljø som heter VisualDSP, dette var riktignok en demo versjon med 60 dagers lisens, men passet bra til vårt formål. VisualDSP har både en Assembler og en C kompilator. Siden C er et litt mer oversiktlig og lettskrevet språk enn Assembler valgte vi å satse på det i utgangspunktet.

VisualDSP sin C kompilator er en omskrivning av den kjente Gnu C Compiler (GCC) for Analog sine signal prosessorer. Denne kompilatoren støtter derfor standard ANSI C funksjoner i tillegg til spesialskrevne signalbehandlings bibliotek fra Analog.

Med tanke på selve utviklingsprosessen valgte vi å først implementere funksjonen til hver enkelt blokk hver for seg for så til slutt å integrere dem i en komplet algoritme.

Siden baktanken med disse blokkene er å bruke de i en sanntids algoritme må stort sett alle variablene være globale slik at de kan oppdateres av mikrokontrolleren. Funksjonene tar derfor ikke imot signaler direkte eller returner noe, men oppdaterer eksisterende variabler.

OSC

Oscillatoren er grunnblokken i en subtraktiv algoritme. Som nevnt tidligere må denne inneholde et rikt harmonisk spekter. Firkant og trekant bølger egner seg derfor ypperlig til dette siden de inneholder en rekke harmoniske komponenter.

Rent teknisk må vi forholde oss til at punktprøvingsfrekvensen er fast 48kHz, altså 48000 punktprøver i sekundet. For å finne ut periode tiden bruker vi formelen

periode =

punktprøvefrekvens/ønsket firkantbølge frekvens

For at frekvensen skal kunne varieres i sanntid må funksjonen lese frekvens, og for hvert sample inkrementere en teller slik at bølgeformen kan genereres.

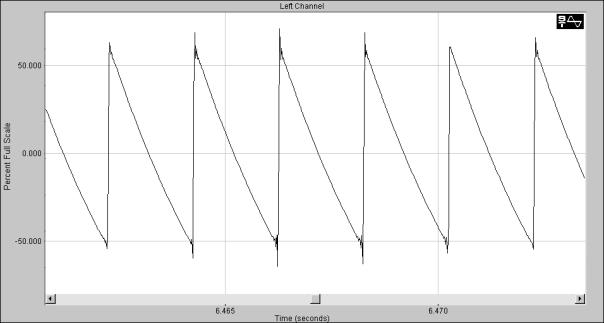

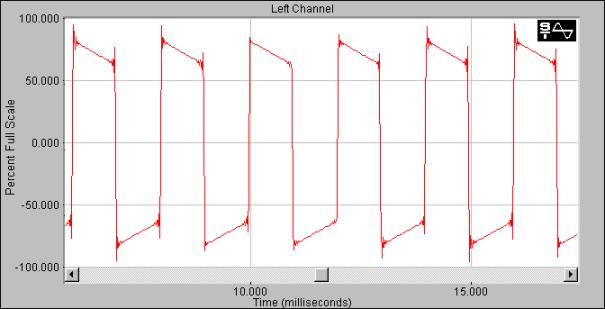

Firkant bølge

En firkant puls har en ganske enkel struktur å programmere siden den er 1 i halve periodetiden og –1 i resten.

Ved å definere variabelen halv_periode kan vi generere en firkant puls på følgende måte:

Figur 45, Firkantbølge programflyt

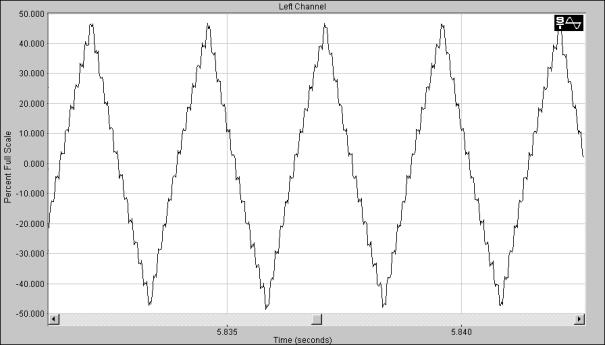

Sagtann bølge

En sagtann puls kalles ofte en rampe fordi den stiger jevnt fra ett nivå til et annet. Ved å la sagtann pulsen gå fra –1 til 1, defineres stigningstallet for flanken som

2*sample_teller/periode –1

Figur 46, Sagtannbølge programflyt

LFO

En LFO er en oscillator med lav frekvens, ofte mellom 0 og 20Hz. Denne brukes som et kontroll signal i andre blokker. Ved analoge synther er LFO ofte av en sinus kurve. Det å generere en sinus med en DSP krever faktisk en del prosessorkraft. Ved å slå opp på side 1-3 i C runtime Library Manual ser vi at en sinus funksjon bruker 45 klokkepulser.

Vi valgte derfor på bruke en trekant bølge istedenfor en sinus. En trekantbølge er enkel å implementere og siden LFO kun brukes som kontrollsignal vil funksjonaliteten omtrent bli den samme. Implementasjonen av en trekantbølge er en blanding av en firkantbølge og en sagtannbølge. Trekantbølgen starter ved –1 for å øke lineært opp til 1, for deretter å minke lineært til –1 igjen. Akkurat som oscillatorene må denne blokken ta frekvens som input.

.

Figur 47, Programflyt LFO

Omhylningskurver

Omhylningskurver er en del mer avanserte enn oscillatorer. En stor forskjell er at omhylningskurver ikke er repetitive slik som oscillatorene. Se ADSR figur.

Omhylningskurven må lese A_tid, D_tid, S_nivå og R_tid slik at disse parametrene er tilgjenglige for brukeren. Hvis disse parameterne ikke er oppdatert leses kurve formen ut av et hurtiglager (cache). Hvis parametrene oppdateres også hurtigbufferet.

Figur 48, programflyt ADSR omhylningskurve

FILTER

Filter blokken er den mest kompliserte funksjonen å implementere. Det største problemet med å implementere denne blokken er at brukeren skal kunne sveipe filteret opp og ned i frekvens i tillegg til å kunne justere resonans toppen i sanntid. Det er også ønskelig å kunne forandre ordenen på filteret. Her er det riktignok ikke så stort krav til sanntids responsen.

Siden filtre er noe av de mest brukte signalbehandlings teknikkene har Analog Devices laget en egen IIR() funksjon i C. Denne tar seg av selve filter algoritmen og iterasjonen av koeffisientene. Vi som brukere må riktignok levere to tabeller med teller og nevnerpolynomets koeffisienter. Disse koeffisientene skal være på den bestemt form som kalles Oppenheim&Schaefer Transposed FormII. Dette er en vri på den kanoniske blokkframstillingen vi var inne på tidligere i oppgaven. Dette har kun med rekkefølgen på koeffisientene legges inn i tabellen å gjøre.

Vi startet med å bruke Billineær transformasjon på et analogt filter. Hensikten med dette var at vi da kunne emulere et høyere ordens filter med mulighet for frekvens sveip og resonans variasjon ved å justere de analoge komponent verdiene.

Det viste seg imidlertid at dette fungerte svært dårlig, trolig av flere årsaker. Den mest åpenbare var at vi ikke hadde kontroll på filterets stabilitet. Det ble ustabilt og derfor helt ubrukelig.

Da vi endelig fattet dette forsøkte vi med Pol og nullpunkts plassering.

En liten nøtt var fortsatt hvordan vi skulle løse problemet med sveipbar frekvens og resonans. Vi kom til slutt fram til at vi måtte generere alle mulige pol plasseringer på forhånd og legge dem inn i en flerdimensjonal tabell. Frekvens og resonans kontrollsignalene kunne da fungere som en indeks for denne tabellen. Hvis vi valgte sammenfallende poler hos filtrene av høyere orden slapp vi også unna med kun en felles tabell.

Det filter algoritmen derfor må gjøre er å først generere alle pol plasseringene. Dette blir gjort kun en gang ved programstart og bør ikke være med i hovedprogramsløyfen. Deretter legges polene inn i en tabell. Funksjonen må i tillegg til frekvens og resonans ta orden som input signal.

Orden avgjør hvordan koeffisientene skal genereres. Når det er gjort må de ferdige koeffisientene legges inn i hver sin tabell slik at IIR() funksjonen kan benytte seg av dem.

For et 2.orden lavpass filterets overførings funksjon på formen :

![]()

Ved å løse tellerpolynomet får vi to sammenfallende nullpunkt ved ±Õ, altså en dempning for frekvensen rundt fs/2

Ved å løse nevner polynomet =0 får vi alltid to komplekskonjugerte poler.

Figur 49, Pol plassering

Ved å ta en tilfeldig kompleks verdi inne i enhetsirkelen kan man regne seg tilbake til nevner polynomet ved :

![]()

Hvor:

![]()

![]()

![]()

og

![]()

I tillegg til A og B koeffisientene må det beregnes en forsterknings konstant slik at filteret får en forsterkning lik 1 ved 0Hz. Dette kalles enhetsforsterkning og finnes ved å sette Z = 1 overføringsfunksjonen. Denne konstanten G finnes derfor ved :

![]()

Den komplette overføringsfunksjonen blir nå :

![]()

Hvis man ønsker et filter av lik orden kan man opphøye overføringsfunksjonen til ønsket orden –2. Hvis man derfor ønsker et 4.ordens filter blir dette:

![]()

På grunnlag av disse funksjonene kan det lages en algoritme som generer 2.ordens koeffisientene.

Vi valgte å lage to separate funksjoner. En som genererer 2.ordens koeffisientene A, B og G, og en som på grunnlag av disse beregner filterets overføringsfunksjon i ønsket orden og lager filter koeffisient tabellene til IIR() funksjonen.

Vi måtte bestemme oss for en filteroppløsning. Denne tabellen blir ganske stor og kan beregnes ved:

Tabellstørrelse = frekvensoppløsning * resonansoppløsning * 3

Ved å bruke en 256 nivåer ender vi opp med en tabell som er 196kB stor, som vi får plass til i minnet.

Filterbank funksjonen kan beskrives som:

Figur 50, Filterbank programflyt.

Den andre funksjonen tar seg av selve koeffisient oppdateringen. Denne må kjøres hver gang brukeren justerer frekvens, resonans eller orden og ser slik ut:

Figur 51, Koeffisientoppdatering.

Samplene kan nå filtreres ved å kalle denne funksjonen:

Figur 52, Filterkall

Panorering

Panorering vil si at en lyds posisjon kan variere fra helt til venstre og helt til høyre i lydbildet.

Dette kan gjøres fysisk korrekt med tanke på oppfattet lydstyrke, ved hjelp av vektor beregninger.

Siden vi kun vi kun er interessert i å implementere funksjonen bruker vi kun en enklere løsning med en panorerings konstant slik at :

Venstre_kanal = mono_sample*pan ..og Høyre_kanal = mono_sample*(1-pan)

Vi

vil nå kunne justere lydens plass i stereobildet, selv om lyden vil oppfattes

litt høyere i midten enn ute på sidene. Som et resultat av denne funksjonen

ender vi oppå med teten venstre og en høyre audio kanal. Blokkskjematisk ser

denne funksjonen slik ut :

Figur 53, Programflyt panorering.

OSC modulasjon

Pulsbredde modulasjon, PWM

Ved å gjøre matematiske funksjoner på oscillatoren vil vi oppnå å få nye og spennende frekvens spektre.

Figur 54, Pulsbreddemodulasjon av firkant som forandrer de harmoniske komponentene, figur hentet fra Clavia Nordlead brukermanual.

Figur 55, Firkant spekter, hentet fra NordLead brukermanual

Pulsbredde modulasjon baserer seg på den vanlige firkantbølgen. Ved å forandre forholdet mellom en periodes positive og negative del oppnåes en forandring i frekvens spekteret.

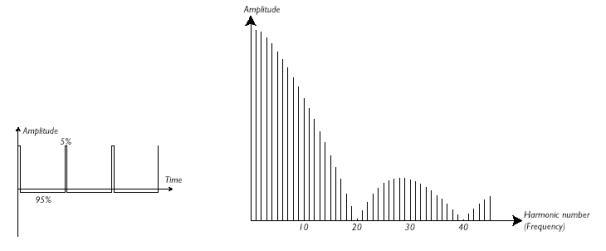

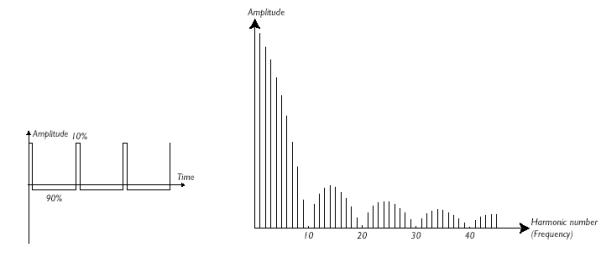

Figurene nedenfor viser forskjellige pulsbreddeforhold og deres respektive frekvens spektre.

Måten PWM kan implementeres er ganske enkelt at halv_periode pekeren som brukes i firkant oscillator funksjonen, kan varieres. Firkant oscillator funksjonen må derfor utvides med en variabel PWM konstant.

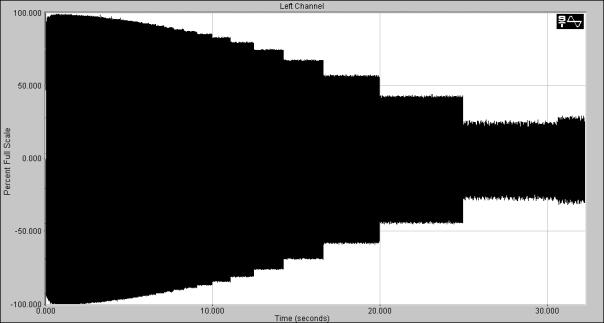

Figur 56, programflyt pulsbreddemodulasjon.